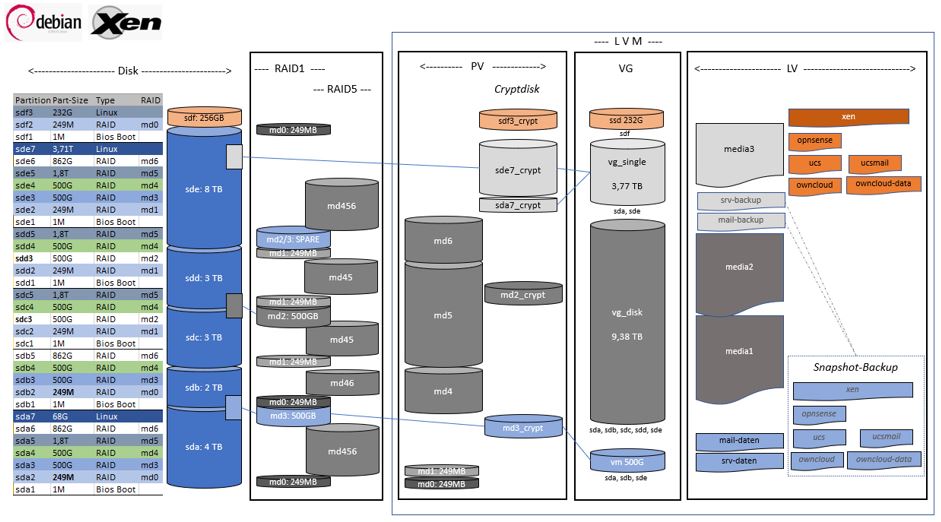

Disk Konfiguration

Mein RAID Setup mit unterschiedlichen Disks.

Anforderungen:

- Eine Disk kann ausfallen, ohne Datenverlust (bis auf den "Verschnitt" in vg_single -> Backup)

- Eine Volume Group vg_single nimmt die Partitionen auf, die in kein RAID mehr passen ("Verschnitt")

- Alle Daten auf mindestens drei unterschiedlichen Disks, soweit möglich

- Alle Daten (Dokumente und VM's) sind verschlüsselt, oder

- im RAID5 (Medien: Musik und Filme) über mindestens drei Disks verteilt (cryptdisk möglich, aber nicht notwendig)

- Alle aktiven VM's liegen auf der einzigen verschlüsselten SSD

- Alle VM's haben ein Snapshot auf einer verschlüsselten Disk

- Der XEN-Host und alle VM'S können im Notfall von allen Disks (md0 oder md1) gebootet werden (auf einem beliebigen anderem Rechner, sofern ein USB-Stick mit dem dem LUKS-Key verfügbar ist)

Mein Bootscript liest den LUKS-Schlüssel zum Booten meines XEN-Servers auf mehreren Devices (USB-Sticks oder Festplatten).

Austausch der 2TB Disk sdb durch eine neue 8TB Disk

Wo wird die Disk verwendet?

RAID

# fdisk -l /dev/sdb Disk /dev/sdb: 1,8 TiB, 2000398934016 bytes, 3907029168 sectors Disk model: WDC WD20EFRX-68A Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 4096 bytes I/O size (minimum/optimal): 4096 bytes / 4096 bytes Disklabel type: gpt Disk identifier: 1FB146D4-AEFD-1C4B-90AF-315105C08C34 Device Start End Sectors Size Type /dev/sdb1 2048 4095 2048 1M BIOS boot /dev/sdb2 4096 514047 509952 249M Linux RAID /dev/sdb3 514048 1049090047 1048576000 500G Linux RAID /dev/sdb4 1049090048 2097666047 1048576000 500G Linux RAID /dev/sdb5 2097666048 3907029134 1809363087 862,8G Linux RAID # cat /proc/mdstat |grep sdb md4 : active raid5 sde4[5] sdd4[3] sdc4[2] sda4[0] sdb4[1] md3 : active raid1 sde3[2](S) sda3[0] sdb3[1] md6 : active raid5 sde6[3] sda6[0] sdb5[1] md0 : active raid1 sda2[2] sdb2[1] sdf2[0]

Disk aus RAID Verbund (RAID 1 mit 3 Disks in md0) lösen:

### md0 : active raid1 sda2[2] sdb2[1] sdf2[0] ### 254912 blocks [3/3] [UUU] # mdadm /dev/md0 --fail /dev/sdb2 --remove /dev/sdb2 mdadm: set /dev/sdb2 faulty in /dev/md0 mdadm: hot removed /dev/sdb2 from /dev/md0 # mdadm --grow /dev/md0 --raid-devices=2 raid_disks for /dev/md0 set to 2 ### md0 : active raid1 sda2[1] sdf2[0] ### 254912 blocks [2/2] [UU]